大模型行研:大模型推理算力应该什么样?

一、AI 训练和推理的区别:学车与开车

对比开车来理解:

AI 的训练是一场漫长的学车过程

- 在学习过大量的交规和教练车实习后,可以上路驾驶阶段,只需学习一次

- 想驾驶货车、摩托车,则需要重新学习

- 家用轿车学习时间短,货车/公交车学习时间长,特种车辆还需要单独学习和训练

AI 的推理则是每一次在道路上开车

- 每次开车需要一些精力,但比学习时花费要少

- 反应时间要短,长了要出事

- 城市道路好开,没学过的山区道路开不好

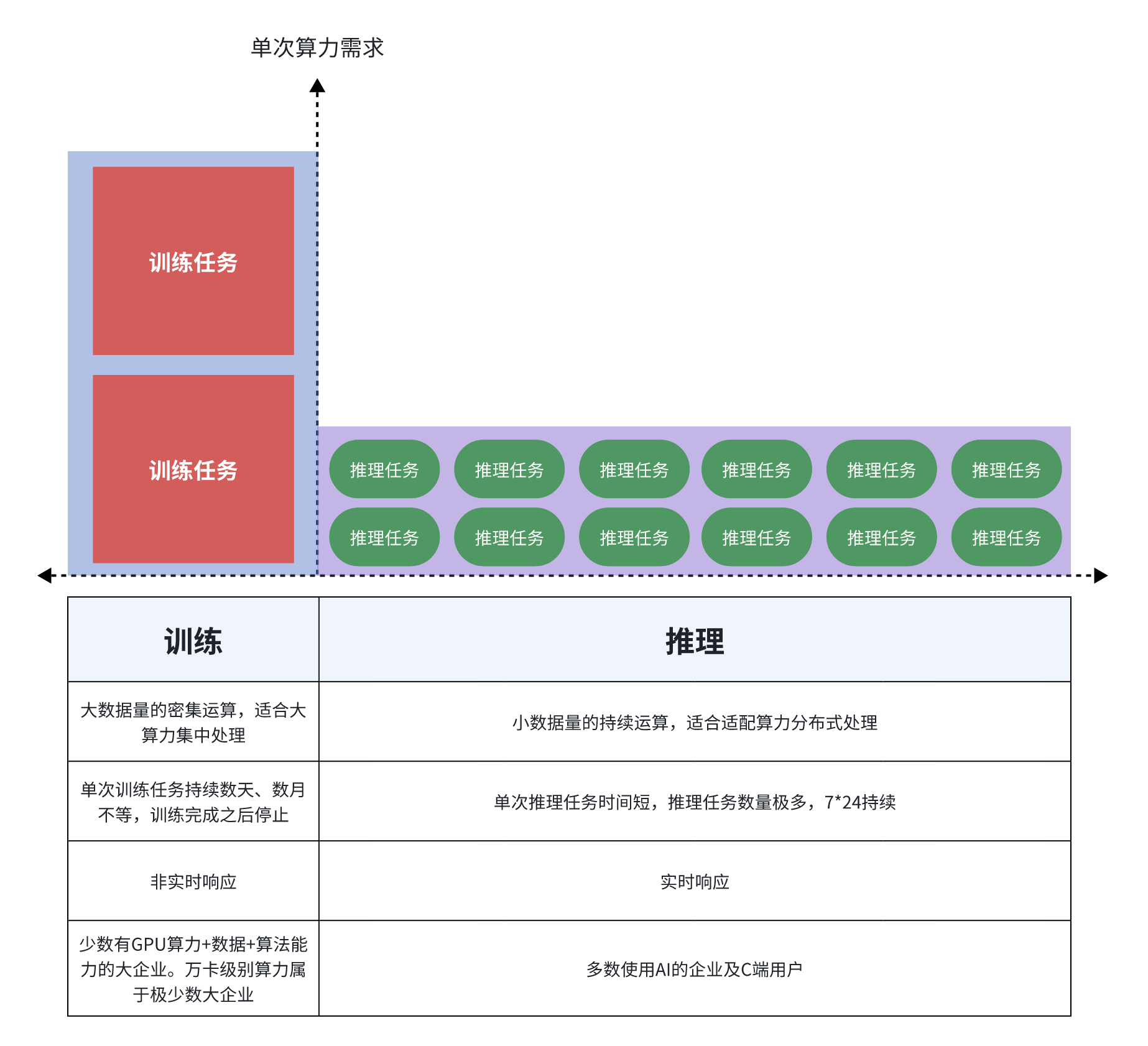

二、算力需求上的特点:成本感知不同

如图所示,AI 到了推理阶段,是成本敏感的:

- 推理任务的次数没有上限,无论开销多么小,总成本都会被次数放大

- 集中式的推理运算,会受到带宽和并发数的影响,保证低时延会极大推高成本

- 现有GPU算力是为训练场景设计的,用于推理场景,是大货车拉小快递,形成算力浪费

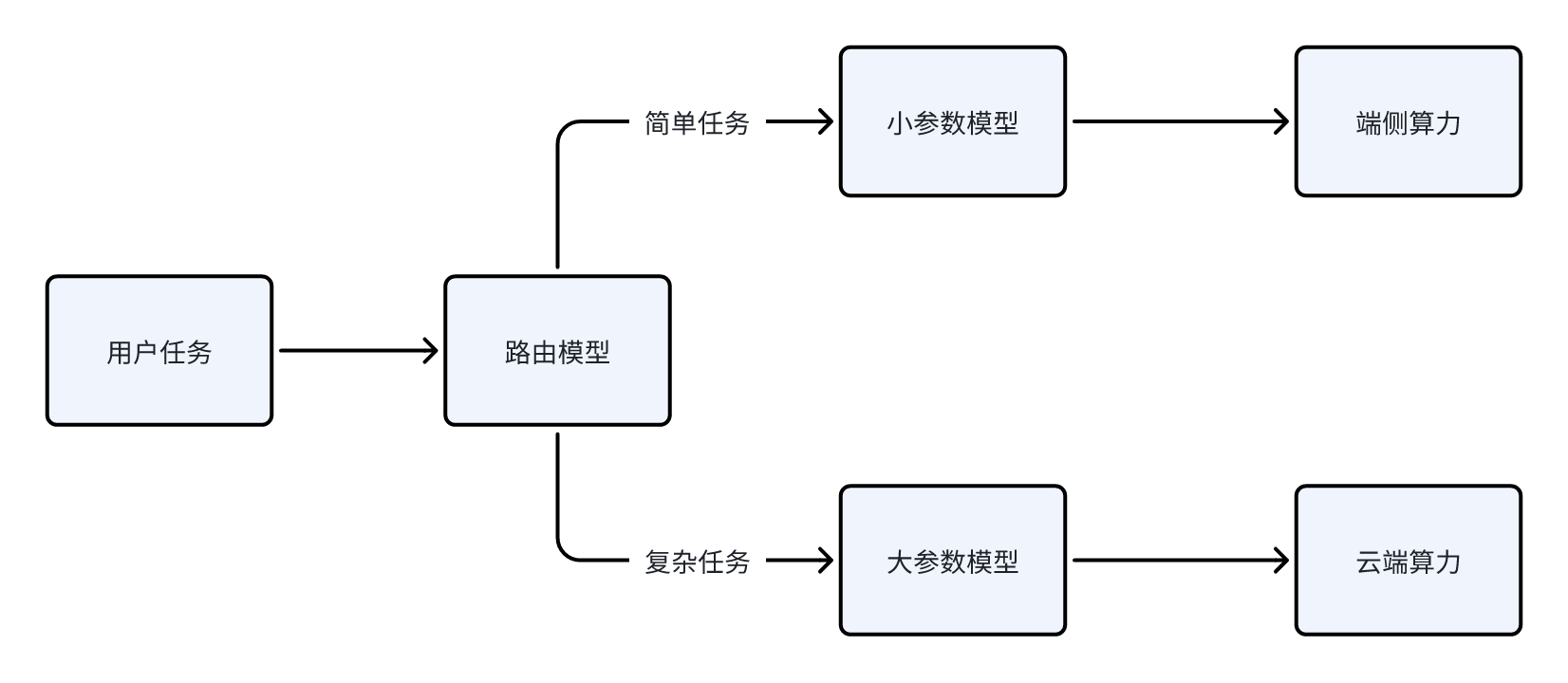

三、AI 大模型的发展方向:大更大,小更小

- 方向一:模型参数规模越来越大,适应各类复杂任务,只能在云端推理

- 方向二:模型参数规模越来越小,适合较简单任务,可以在手持设备推理

两种方向都有对应的使用场景,但是不能错配,比较现实的方式是前置一个路由模型,将用户任务分类给不同的模型

在可预见的使用场景中,多数任务都是较简单,可以被小参数模型处理的,即使在未来出现高频次的“复杂任务”,也可以使用大参数模型处理后,将“能力”下放给小参数模型,让“复杂任务”重新变成“简单任务”。

四、推理芯片的模样:高并发、高吞吐、低成本

从推理任务的特征看,理想的推理芯片具备如下特征:

- 高并发:单核算力不需要很高,核心数量可以更多

- 高吞吐:带宽要求高,缓存/内存/显存要足够高,芯片与硬盘之间的I/O高

- 低成本:制造成本低,能耗低,最好能复用存量算力

市场上有多条实现路径:

- 高端专有推理芯片:如面向transformer的专有芯片,成本高效果好

- CPU:多核CPU,还可复用大数据时代的算力

- 低端GPU:做过算子优化的低端GPU集群

- 其他异构算力:NPU、TPU、DPU等,通常与CPU协同,有工程成本

高端专有芯片适合集中式的推理计算,低端的异构算力适合分布式的推理计算

五、RISC-V路线:开放、高低即可

RISC-V 芯片在AI推理场景,有自己的优势:

- 开放:任何厂商都可以做算子适配,软硬件协同优化

- 高低皆可:原生的模块化,可定制性,可以做高端算力,也可以做低成本算力

- 便宜:低功耗,无授权费用,可使用低成本制程,与其他芯片协同,进入各类IoT市场