AI 偏见和歧视,需要穿透审查基础数据

为了避免 AI 算法产生偏见和歧视,可能要求穿透审查 AI 算法的基础数据,也就是基于样本可解释性,审查那些用于训练算法模型的被采集标注的样本是否带有偏向性。

举个例子,美图秀秀的 AI 修图模型,使用了大量的东方人面部数据,在处理西方人面部时,不可避免会偏向东方人的面部特征,这里产生了一种模型上的“偏见”,所谓穿透审查,就是要求在训练修图模型时,对各地区、各人种、各肤色等等特征,在基础数据上进行公平分配。

在各国纷纷出台涉及 AI 算法规范的前提下,为了避免出现这样的偏见或歧视而产生的市场反应,会是什么样的?在样本可解释性上,很有可能出现一个“合规数据集”市场,有一类专业的基础数据提供厂商,会为算法训练提供能通过“反歧视”审查的标注数据,这些标注数据甚至会形成一个可重复交易的市场。这样的基础数据服务厂商可能有这样一些要求:

- 熟悉欧盟、美国及其他地区的反歧视规则和审查机制

- 具备从分散的数据源获取数据和标注的能力

- 从工具链和管理上,同时具备通过安全性审查和反歧视审查的能力

算法的可解释性是个前沿性话题,各大公司都在做探索,比如谷歌的 X AI 计划与模型卡(Google Model Cards),大致上可以理解成,为算法输出一张“药物说明书”,告知公众算法的基本机制和关键限制要素。

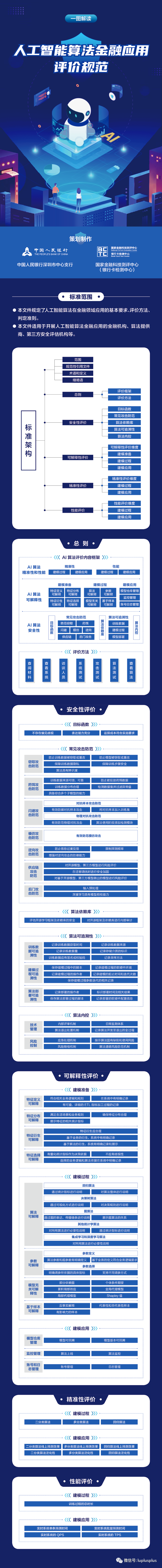

中国人民银行发布了《人工智能算法金融应用评价规范》,并于3月26日起正式实施,是一个成熟度很高的行业规范,可以应用在通用型 AI 算法的评估上,如图:

图片来自 https://www.sohu.com/a/459835930_672569

标签:无